SMOTE相关研究

Borderline-SMOTE:

Borderline-SMOTE: A New Over-Sampling Method in

Imbalanced Data Sets Learning

motivation:

有些样本远离边界,所以对分类没有多大帮助,可以强化边界点。

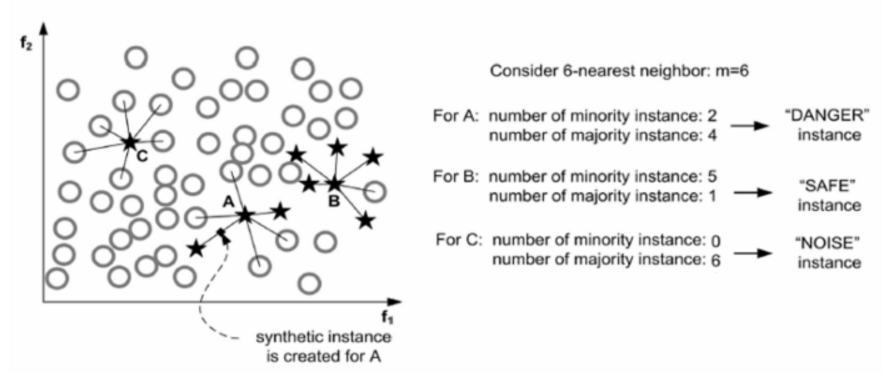

思路:

将少数类样本根据距离多数类样本的距离分为noise,safe,danger三类样本集,只对danger中的样本集合使用smote算法。

1 | For each point p in S: |

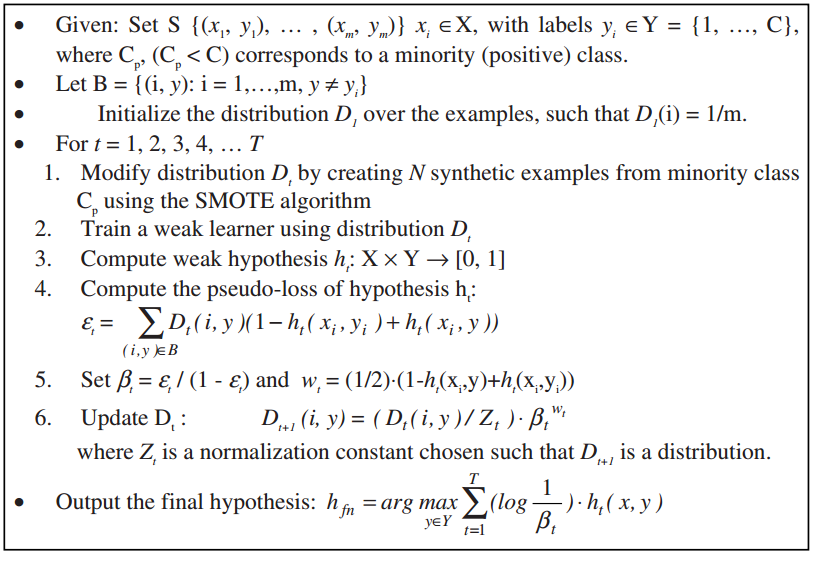

SMOTEBoost:

SMOTEBoost: Improving Prediction

of the Minority Class in Boosting

与集成学习相结合

AND-SMOTE:

Automatic Determination of Neighborhood Size in SMOTE

motivation:

smote算法中有一个参数k,不合适的k值会导致合成的少数类样本进入多数类样本中,由此产生了噪声,妨碍分类的进行。

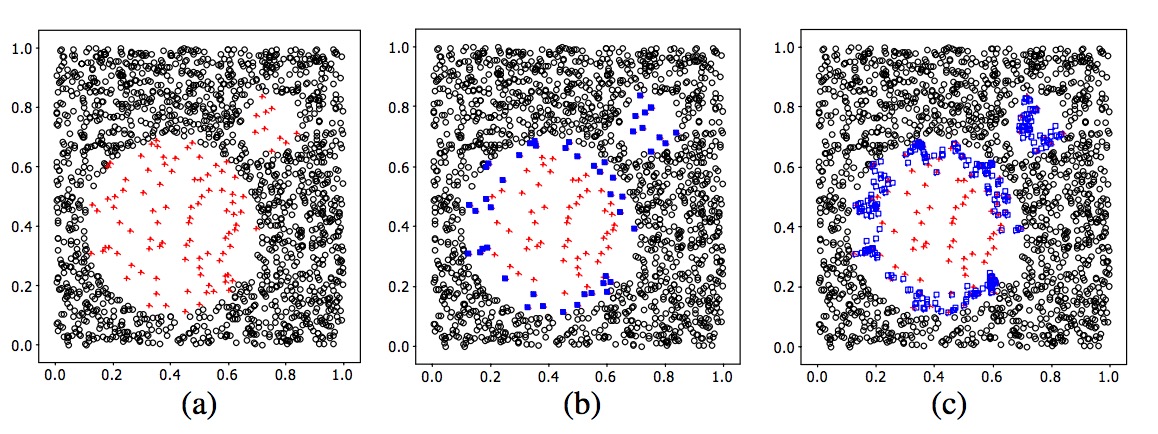

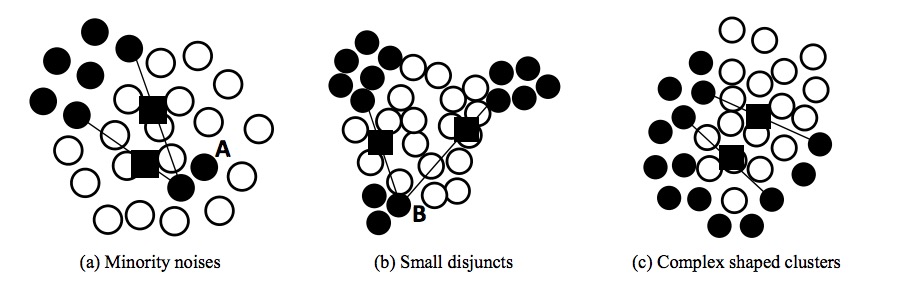

如下图黑色圆是少数类,白色圆是多数类,黑方框是合成的少数类。分别对应三种问题,数据中包含noises,small disjuncts,complex shaped clusters

思路:

提出一种AND(Automatic Neighborhood size Determination)方法,对每个少数类产生合适的近邻样本 K=(k1,k2…..kt),t是少数类样本的个数。然后将AND的输出作为smote算法中每个少数类样本近邻的输入。

C_SMOTE:

motivation:

1、K值的选择有一定的盲目性,如何选择最优K值

2、若负类样本处于正负类的边界,则合成的新样本也有可能处于分类边缘,且越来越边缘化,边界变得模糊,加大分类难度。

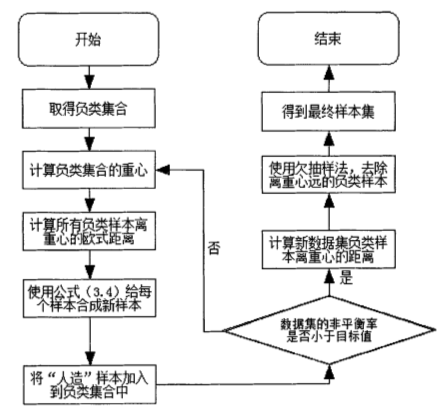

思路:

围绕少数类重心产生样本,C_SMOTE不需要选择K个近邻,使新产生的少数类样本向重心趋近,不会偏离出少数类的样本

SMOTE-DGC:

SMOTE-DGC: An Imbalanced Learning Approach of Data Gravitation Based Classification

motivation:

针对DGC这个分类器不平衡问题提出解决方案。将smote算法和DGC分类器组合,DGC(data gravitation-based classification )是本文作者之前做的一个分类器.

SMOTE-D:

SMOTE-D a Deterministic Version of SMOT

motivation

smote算法中每个少数类有K个近邻,再从K个样本中随机挑选m个样本用于合成样本。这就有一定的随机性,每次使用smote的时候都会产生不同的样本分布。

思路

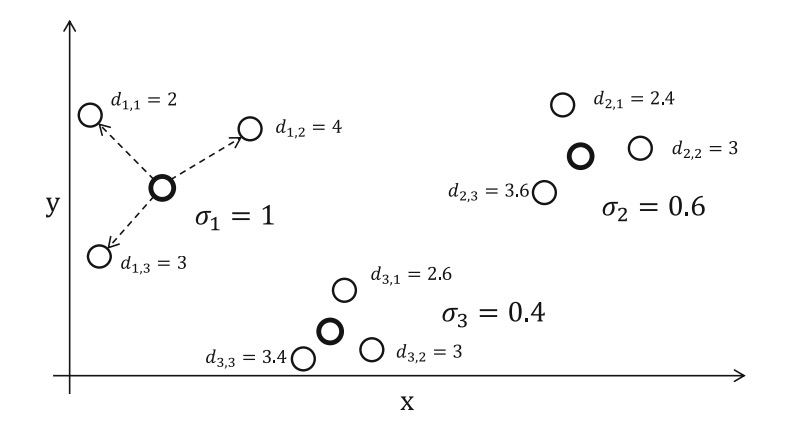

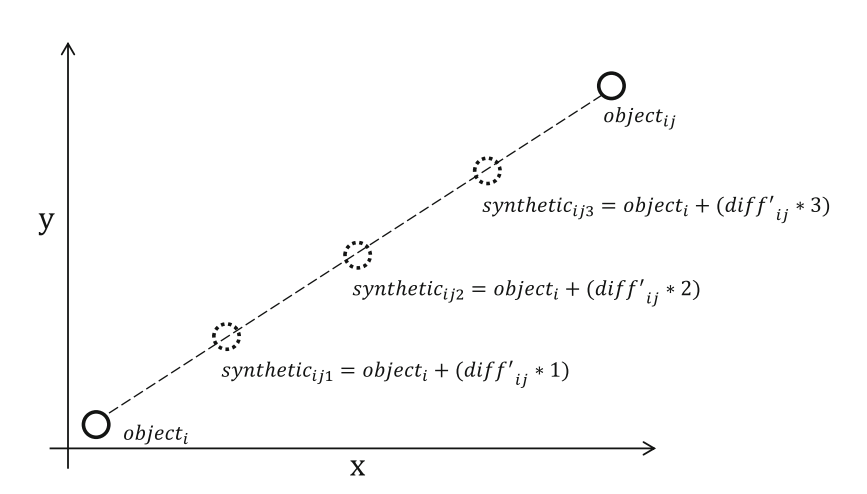

对每个少数类样本的K个近邻,计算每个少数类样本到K个近邻的距离,然后求样本标准差,计算每个样本标准差占总体少数类样本标准差的比例。如下图。

对于样本1,标准差占的比例为1/(1+0.4+0.6)=0.5,如果有10个少数类样本要生成,则样本1合成其中的5个。对于这5个样本再按照一定的方法分配给K个近邻,其中近邻距离越长,合成的样本越多。

Safe-Level-SMOTE

motivation

smote盲目生成少数类的区域,导致少数类的样本区域变得更大,决策边界也变得更加不明确。所以要有控制的生成样本。

思路

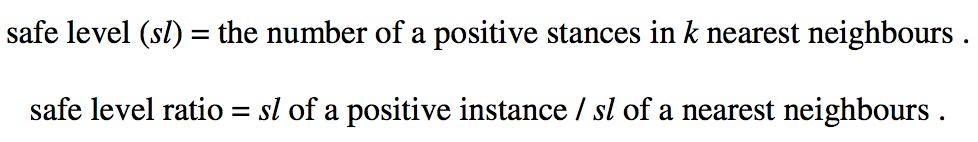

对于每个少数类样本p,计算它的最近邻K个样本,从K个样本中随机选择一个样本n,记p的K个最近邻和n的K个最近邻为slp和sln,safe level ratio就是slp和sln的比率,通过比率调节生成的样本是靠近p还是靠近n

Random-SMOTE

A new over-sampling approach: Random-SMOTE for learning from imbalanced data sets

motivation

SMOTE方法只是在相邻近的小类样本之间线性插值,插值

的结果是小类样本密集的地方依然相对密集,小类样本稀疏的地方依然相对稀疏。这样,

处在稀疏区域的样本,分类算法不易识别,容易出现误分。因此,SMOTE对某些处在

稀疏区域的未知小类样本的分类效果将不明显。

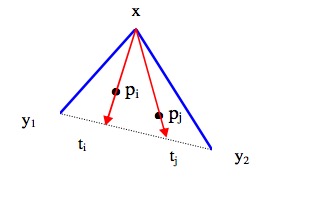

思路

对于每个少数类样本x,从少数类集合中随机选择两个样本y1和y2,以x、y1、y2为顶点构成一个三角形区域;根据过采样倍率N,在该三角形区域内随机生成N个新的少数类样本。